Директор по криптографии компании Avanpost Евгений Галкин о необходимости государственного регулирования ИИ

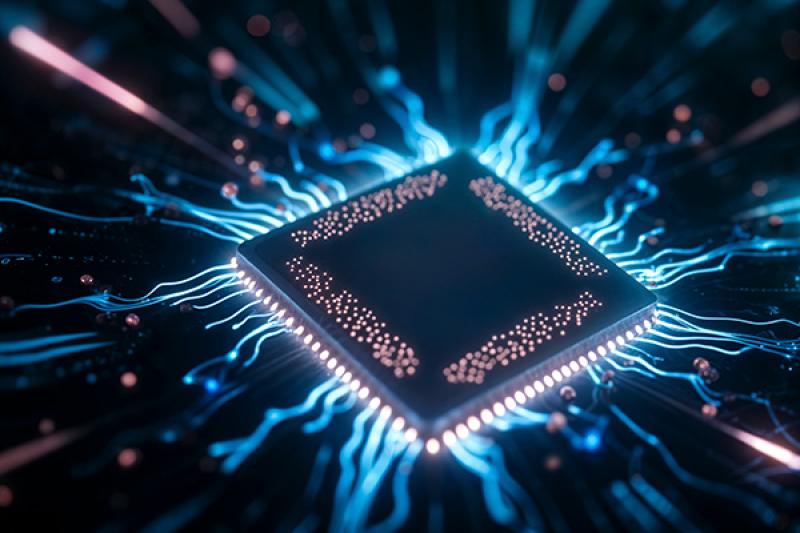

ИИ, очевидно, — новая веха в технологическом развитии и сфере IT, которая, одновременно с многочисленными возможностями, приносит с собой совершенно новый класс угроз ИБ. Эти угрозы кардинально отличаются по своему характеру от тех, с которыми мы сталкивались ранее. К примеру, уже сейчас стоит задача фильтрации небезопасного контента, чтобы предотвратить ситуацию, когда любой пользователь мог бы спросить у ИИ, как создать бомбу или иные опасные объекты. На другом конце спектра — возможность использования искусственного интеллекта для создания эксплойтов, вредоносных скриптов и даже вирусов. Фактически, написание программного вредоносного кода становится задачей, с которой ИИ может справляться эффективно.

В связи с этим очевидна необходимость регулирования этой сферы. Вопрос лишь в том, когда именно регуляторика коснётся искусственного интеллекта на государственном уровне — и для России этот момент, видимо, наступает сейчас. Хотя я ещё два года назад подчеркивал важность комплексного внимания к этой теме.

При этом стоит подчеркнуть, что создание системы регулирования ИИ — глобальная задача. Её реализуют не только в России, но и в таких регионах как США и Европейский союз, где основной целью является обеспечение безопасности и предотвращение появления «злого» искусственного интеллекта. Российские органы, в том числе ФСТЭК, следуют мировым тенденциям и уже разрабатывают соответствующие распоряжения и методики.

Остаётся открытым вопрос, должно ли регулирование быть связано именно с безопасной разработкой ИИ-продуктов, или эта тема может быть оформлена отдельными юридическими нормами. Например, у нас защита персональных данных регулируется отдельно от вопросов безопасной разработки, хотя требования распространяются и на системы защиты персональных данных. В целом, факт необходимости регуляторики информационной безопасности в ИИ-сфере вне всяких сомнений, и Россия движется в ногу с мировыми трендами.

Что касается самой разработки регулирующих методик, их создание обязательно должно проходить с участием рынка — тех, на кого эти нормы в конечном итоге будут распространяться, и IT-сообщества в целом. ФСТЭК, по моему мнению, достаточно открыт к диалогу и сейчас — это видно на примере работы по безопасной разработке и сертификации, однако взаимодействия с отраслью должно быть больше.

В регламенте, безусловно, должны быть прописаны основные меры, направленные на фильтрацию контента: обеспечение вывода пользователю исключительно безопасной информации, контроль над действиями ИИ-агентов, ограничение использования ненормативной лексики или информации, нарушающей гражданские права и свободы. Искусственный интеллект — это новый уровень, он обладает элементами «интеллекта», поэтому и регуляторные меры должны учитывать особенности его интеллектуальной деятельности, сравнимые с регулированием человеческих действий. Здесь речь идёт о специфическом слое регулирования, который обеспечивает безопасность на стыке человека и машины.

Похоже, что в ближайшее время в России будет создана новая институция, отвечающая за информационную безопасность в области ИИ, а вокруг неё сформируется соответствующая отрасль. Так же, как когда-то появилась индустрия вокруг систем баз данных и защиты информации. Для тех, кто планирует работать в этой сфере, сейчас самое время задуматься об открытии лабораторий, центров и других структур: это не только вопрос безопасности, но и перспективный бизнес будущего.

Фото: Avanpost