Не буди ссылку: пользователей хотят избавить от навязчивых рекомендаций в интернете

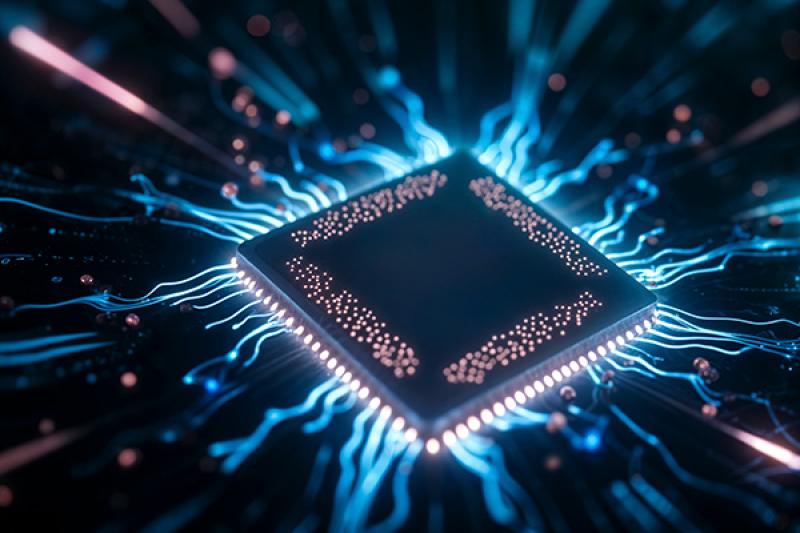

Черный ящик

Работу рекомендательных систем хотят начать выстраивать с учетом мнения пользователей интернета, они должны дать добровольное согласие на просмотр такого контента — об этом «Известиям» сообщили в одной из структур Роскомнадзора. Речь о рекомендациях, которые применяют различные интернет-сервисы. Это позволило бы оградить детей от жестокого и неподходящего по возрасту контента, а пожилых и людей в сложной жизненной ситуации — от навязчивых предложений кредитов, ссылок и фишинговых ресурсов.

Сейчас рекомендательные системы сравнимы с «черным ящиком». Корпорация-владелец, равно как и пользователь, далеко не всегда могут осознавать, почему РС предлагают человеку ту или иную информацию, тот или иной контекст. Именно на это и обращают внимание специалисты подведомственных Роскомнадзору учреждений. Эксперты считают, что пользователи сами должны решать, какой контент им бы хотелось видеть, и задавать кастомные параметры алгоритмам.

В настоящее время посетители сайтов, отмечают аналитики, не могут контролировать взаимодействие с РС полноценно. Когда пользователю демонстрируют контент, от потребления которого он решил отказаться, он может поставить дизлайк, написать гневный комментарий или же попросить систему не направлять впредь ему подобную информацию, но ни один из этих инструментов не будет универсально эффективным.

Если бы решения рекомендательной системы были более прозрачны, а пользователь мог бы участвовать в формировании параметров своего профиля, РС были бы намного полезнее, рассуждают специалисты.

В пресс-службе Роскомнадзора отмечают, что действующее правовое регулирование рекомендательных систем гибкое, поскольку многие из них базируются на сложных технологиях, в том числе используют нейросети. По закону, говорят в РКН, пользователи должны быть проинформированы, что им предоставляются сведения с применением подобных технологий, ознакомлены с правилами их работы. В настоящее время, полагают в пресс-службе РКН, острой необходимости в изменениях нет.

«Известия» направили запросы в отдел контроля ФСТЭК России.

Двери недобросовестности

Руководитель продукта Solar webProxy ГК «Солар» Анастасия Хвещеник полагает, что даже опытным пользователям не всегда очевидно, как повлиять на рекомендательные алгоритмы. Тем более это затруднительно для уязвимых категорий граждан или тех, кто склонен к импульсивным реакциям. Однако стоит учитывать, что благодаря подобным алгоритмам полезные рекомендации тоже получают широкое распространение.

Усиление контроля со стороны платформ над классификацией материалов в разряде 18+ могло бы существенно улучшить ситуацию, уверена Хвещеник. По ее суждению, простое согласие пользователей на использование рекомендательных алгоритмов без строгого определения содержания контента не защитит наиболее уязвимых лиц.

Управляющий партнер Mindsmith Руслан Юсуфов поясняет, что в большинстве своем алгоритмы работают на основе персональных данных. Первая самая очевидная опасность — их утечка: сведения продаются, покупаются и используются не по назначению. Помимо этого, фильтрация рекомендаций не всегда происходит качественно, что может приводить к распространению нежелательного контента; в случае детей — материалов, содержащих жестокость, насилие. Для пенсионеров подобной угрозой будут фишинговые ссылки, дезинформация, вовлечение в мошеннические схемы.

— Также одна из основных функций рекомендательных систем — удержание внимания и повышение эффективности предлагаемого контента, — указывает Руслан Юсуфов. — Опасность состоит в формировании у пользователей зависимости от алгоритмов. У алгоритмов нет моральных установок, есть цели, закладываемые и управляемые владельцами и разработчиками.

Например, после покупки Илоном Маском компании X (бывший Twitter) у пользователей в ленте стали появляться посты из его личного аккаунта, даже у тех, кто не был на него подписан. Этот пример еще достаточно безобидный — компании могут использовать системы в своих интересах, в том числе для продвижения определенной повестки менее заметными и более изящными способами.

При этом эксперт Юсуфов выступает против запрета рекомендательных алгоритмов, поскольку, например, для бизнеса это может обернуться огромными издержками, потребностью в поиске прибыли в другой юрисдикции или способа обхода закона, что приведет к использованию тех же алгоритмов (или чего-то похожего) с теми же (а возможно, даже худшими) эффектами.

По мнению собеседника, полезным решением может стать настройка алгоритмов самим пользователем. Дело в том, что еще одна опасность заключается в том, что результаты просмотра определенных видео, переходов на каналы и другой активности в Сети непрозрачны. Так, человек может случайно засорить свой профиль и, сам того не желая, сформировать рекомендации, например, радикального или экстремистского характера.

— Алгоритм не знает, что пользователь хочет от своей жизни, какие цели ставит перед собой, он не понимает, осознанно просмотрено то или иное видео или рефлекторно, — рассуждает Руслан Юсуфов. — Так возникает конфликт намерений пользователя и рекомендательной системы, хотя, казалось бы, ее функция — помощь в выборе.

Пленники информационных «пузырей»

В реальности алгоритмы ощутимо влияют на картину мира пользователей интернета. Они могут загонять людей в информационные «пузыри», ограничивать наше восприятие и усиливать предрассудки, замечает руководитель web-направления «Первый Бит» Ольга Медведкова. При этом сам пользователь может и не подозревать, что его картина мира подчиняется не ему.

— Это известная проблема, но попытки ее решения пока что можно назвать точечными, — говорит Ольга Медведкова. — Например, YouTube с 2019 года развивает систему, которая призвана убрать из алгоритмических рекомендаций видео о теориях заговора — «плоской земле», «лунной афере» и других. Однако само определение дезинформации глубоко субъективно, поэтому полностью ограничить распространение вредного контента кажется невозможным, если не менять саму базовую идею алгоритмических рекомендаций.

Эксперт убеждена, что вопрос стоит подкрепить законодательно. Если на правовом уровне побудить владельцев платформ делать алгоритмы прозрачными и настраиваемыми, а также сформулировать определенные этические правила для них, это может действительно обезопасить людей от дезинформации и травмирующего контента.

Также, по ее мнению, стоит активнее регулировать распространение мошеннических схем, особенно нацеленных на детей, несовершеннолетних и пенсионеров.

— Необходимо привлекать к ответственности за распространение не только мошенников, но и сами площадки, которые допускают такой контент, — отмечает Ольга Медведкова. — При этом еще более эффективным может стать создание образовательных программ.

В свою очередь, эксперт «Лаборатории Касперского» по контентному анализу Анна Ларкина полагает, что формирование информационных пузырей, с одной стороны, позволяет удобно настроить поиск для пользователей, но с другой — может вызывать недовольство тех, кто очень серьезно относится к цифровой приватности.

— Но важно понимать, что, отключив их полностью, пользователь столкнется с большим количеством неинтересной и ненужной ему информации, — отмечает спикер.

Например, на видеохостинге ребенок, у которого включены рекомендательные алгоритмы, будет видеть мультики, обзоры игр и другие релевантные ролики, но если настройки сбросить, то ребенку начнут показывать все возможные видео, от политических передач до советов по ремонту и кулинарных шоу.

Руководитель отдела бизнес-автоматизации IT-компании SimbirSoft Виктория Реутская считает, что работа по устранению рисков со стороны рекомендательных алгоритмов должна проводиться комплексно.

— Со стороны государства должны предприниматься меры по контролю за использованием персональных данных детей, вводиться возрастные ограничения на контент, — подчеркивает Реутская. — При этом не все алгоритмы используют одинаковые методы, поэтому при отказе от одной рекламы может появиться другая. Быстрое развитие технологий влечет за собой необходимость постоянной настройки конфиденциальности и указания нежелательной рекламы.

Дмитрий Алексеев